Please select, bitte wählen Sie aus, veuillez choisir, por favor, seleccione↑↓

Data∙Science∙Investigation∙History∙Media∙Art

Verena Hanko

MA MAEIS

Policy Officer in European and International Organisations

🇦🇹🇪🇺

EDUCATION

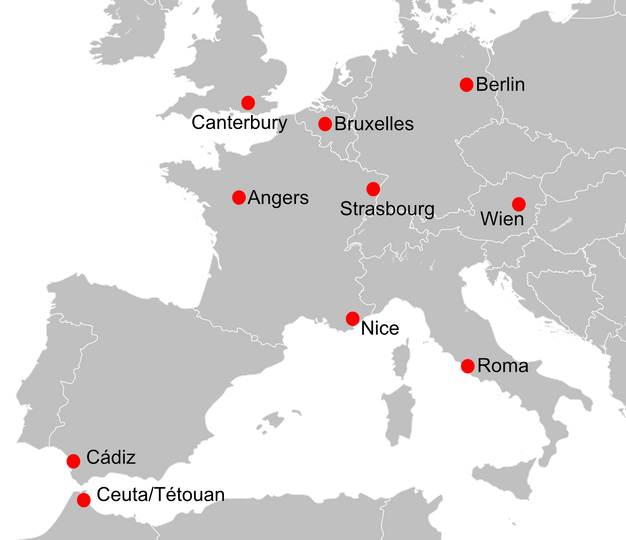

2019/20 Masterstudium „Advanced European and International Studies (MAEIS) – European Policy and Governance”, Trilingual Studies, CIFE (Centre International de Formation Européenne), Nizza, Canterbury, Berlin

2018 Lehrgang „Medienkompetenz – Inspirationen, Werte und Interkulturalität für eine zeitgerechte Mediengestaltung“, Wien, Figlhaus

2017/18 Lehrgang „Neuer Schwung für Europa“ des CIFE, Ausbildung zur EU-Expertin, Wien, Figlhaus

2016/19 Masterstudium „Romanistik“ (Hauptfach Französisch), Fokus „Interkulturelle Kommunikation“, Universität Wien

2014/15 Erasmus-Semester an der Université catholique de l’ouest (UCO), Angers, Frankreich

2012/16 Doppelstudium Bachelor „Romanistik“ und „Philosophie“, Universität Wien

2011 Gymnasium GRG 15 Auf der Schmelz, Sprachzweig (Englisch/Französisch), Matura mit ausgezeichnetem Erfolg

WORK

2021/ Fach-Referentin für Integration Österr. Bundeskanzleramt

Sektion II - Integration, Kultusamt und Volksgruppen

Abteilung II/2 – Integrationskoordination

Referat Wissensmanagement und Integrationsmonitoring

2019 Projekt-Mitarbeiterin „Talk-Team Figlhaus“, Organisation von Podiumsdiskussionen in den Bereichen Politik, Kultur und Medien

2017/18 Marketing-Assistentin, Tageszeitung „derStandard“, Kundenberatung

2017 Hilfswissenschaftlerin am Forschungskongress „Vienna’s Role in the Development of the Mind Sciences“ an der Universität Wien, Gästeempfang- und Betreuung

2014 Tutorin im Fach „Logik“ (Philosophie) an der Universität Wien

2012/18 Lernquadrat, Nachhilfe in den Fächern „Französisch“ und "Englisch"

2012/13 Tanz-Lehrerin, Tanzschule Stanek, Wien

PAPERS

2020 „Das bedingungslose Grundeinkommen – ein soziales Modell für Europa?“, Masterarbeit

2019 „L’intelligence artificielle et la société de données à l’exemple d’une analyse de discours du scandale « Facebook - Cambridge Analytica » dans la presse française“, Masterarbeit

2020 „Spreading human rights and democracy? – The EU as a normative actor in times of change“, Artikel für das akademische Journal Kent Political Almanac special edition, University of Kent

2016 "Hast du un stylo ? Analyse syntaxique des alternances codiques à l'exemple du couple de langue français - allemand", Bachelorarbeit

2016 "La conversation française en tant que lieu de mémoire", Bachelorarbeit

2020 "Report on Austria’s economy" macroeconomic, macrosocial, demographic and international indicators, CIFE

2020 "The mediation in the Bosnia war (1992-1995) - An analysis of the U.S. mediation in the Dayton Peace Agreement", University of Kent

DATA - SCIENCE - INVESTIGATION - HISTORY - MEDIA - ART

HEINZ M. HANKO

global contact

NOBILEGASSE 40

1150 WIEN

AUSTRIA

regular email

confidential/encrypted email

HANKO@PROTONMAIL.CH

text/signal

Threema: BYU7EB46

(not available on any platforms as Instagram, Facebook, LinkedIn, Xing, TikTok, etc - no clouds)